研究におけるAI: 可能性と課題

MAXQDA Blog 翻訳版

Wednesday, May 29, 2024

2月29日にベルリンで開催されたMQIC 2024で行われた(質的)研究におけるAIの可能性と課題に関するシンポジウムの記録

パネリスト

Dr Karen Andes

Professor at Brown University

Julia Gerson

Chief Product Manager of MAXQDA

Dr Udo Kuckartz

Professor Emeritus at Philipps University Marburg

Dr Stefan Rädiker

Research Consultant, research-coaching.de

モデレーター

Andreas Müller

Research Consultant, muellermixedmethods.com

はじめに

今年のMAXQDAインターナショナル・カンファレンス(MQIC)では、インタラクティブなシンポジウムディスカッションが行われ、4人のパネリストが研究におけAI、特に質的研究におけるAIの可能性と課題について議論しました。ディスカッションには、聴衆からの質問やコメントも取り入れられました。

4人のパネリストは以下の3つの主要な問いに対する発表を準備するよう事前に依頼されました:

- 自身の研究分野や業務において、AIの使用にはどのような可能性があると考えていますか?

- 自身の研究分野や業務において、AIに関してどのような課題に直面していますか?

- MAXQDA内でのAI Assistの実装に関して:

- AI Assistが生成する分析結果をどのように理解しますか?

- データの分析ワークフローは、現在および今後の展望も含め、どのように変わりますか?

パネリストは各問いに対する発表内容を視覚的にサポートするため、各自の視点に合った画像を作成または選択しました。シンポジウムのディスカッションは、主要な質問ごとに構造化され、最初に各パネリストが画像を提示し、90~120秒の時間枠で自分の見解を説明しました。その後、参加者同士が画像と主張についてコメントし合い、最後に聴衆の参加が促されました。

このドキュメントは、シンポジウムで取り上げられた主要な議論、洞察、および討論のポイントを3つの質問ごとにまとめ、最後にいくつかの結論的なコメントを加えたものです。なお、ディスカッションで表明された意見は、必ずしもパネリストの意見を反映するものではありません。

1) 研究におけるAIの可能性

- 自身の研究分野や業務において、AIの使用にはどのような可能性があると考えていますか?

Stefan Rädiker

研究におけるAIの可能性の一つは、新しい有望な分析手法の出現です。何人かの研究者は、AI支援による要約やデータとの対話が、データのコーディングという現在のアプローチよりも重要になると主張しています。特にテーマ別コーディングに関しては、コーディングプロセスを省略してデータ内のトピックを特定し、要約することがすでに可能であるため、これは正しいかもしれません。 テーマ別コーディングの終焉を示す墓石と死亡日を示す画像を見せることも考えましたが、あまりにも挑発的なので、引退という比喩にしました。コーディングとテーマ別コーディングの概念は生き続けるべきであり、長い歴史と正当な理由があると確信しています。しかし、テーマ別コーディングが新しい方法に変わる可能性があると考えています。

Karen Andes

私は世間知らずな教授の画像を示します。パネルに参加するよう求められたとき、まずChatGPTにスピーチを作成してもらいました。そこでは、帰納的および演繹的コーディングに触れられていましたが、それについては話しません。正直に言うと、最初は懐疑的でした。しかし、MAXQDAに実装されている様子を見て、特に学生にとっての可能性に興奮しました。学生は常に自分が正しいことをしているか確認したがり、課題をこなしたいと思っています。テーマ別分析を依頼すると、誰かがうまくやった課題の例を見たがります。AIが研究のパートナーとして、学生に出発点や比較対象を提供する機会があると感じています。これは、チームワークの模倣にもつながるかもしれません。

Julia Gerson

私の画像は学習環境で年中無休のアシスタントとしてのAIを描いています。学生が寮の部屋でラップトップで作業している様子が描かれており、机の上には知識豊富なガイドや教師を象徴するフィギュアが入ったスノードームがあります。このAIガイドは、学生が現在取り組んでいる非常に具体的なトピックの専門家ではないかもしれませんが、すべての想像可能なトピック、特に研究やMAXQDA関連のトピックに関する教科書的な知識を持っています。

学生は、AIに「10歳の子供に説明するように」とグラウンデッド・セオリーを説明させることができます。これにより、レゴブロックや探偵がブロックを組み合わせてさまざまなモデルを作るといった楽しい回答が得られます。

私もプロダクトマネージャーとして会議やスピーチの計画時に一般的なヒントを得たり、デザインモックアップに対するフィードバックを受けたりするためにAIを活用しています。

AIは専門的な知識を置き換えることはできませんが、その広範な知識と常時利用可能な点で大きなサポートを提供します。例えば、MAXQDAマニュアルでは、チャットボットが即時サポートを提供しており、AIの価値を示しています。

結論として、AIは教育および職業の両方の場面で、質問に答え、概念を説明し、貴重なフィードバックを提供するための重要なツールとなります。

Udo Kuckartz

私が持ってきた最初の画像は、社会研究の未来の可能性を示しています。ここでは、AIによってサポートされる研究チームが描かれています。AIは社会科学研究において大きな機会を提供し、効率と生産性を向上させ、例えば文字起こしのような多くのタスクを自動化することができます。AIは執筆やプレゼンテーションにも役立ちます。研究者は、文字起こしやコーディングといった運用タスクから解放され、集中的な分析やリサーチクエスチョンへの回答に集中できます。全体として、データ分析はより動的でインタラクティブなものになるでしょう。

今日の状況は1980年代を思い出させます。ちょうど40年前の1984年、 質的データのコンピュータ支援分析の可能性を探求し、適切なソフトウェアを開発し始めました。ソフトウェアの使用が質的データ分析のプロセスを大きく変えることは明らかでした。当時、グラウンデッド・セオリーの共著者であるバーニー・グレイザーなどからの強い反対がありました。QDAソフトウェアが質的データ分析の標準となるまでには比較的長い時間がかかりました。AIについても同じようなことが起こるでしょう。おそらく今日ではすべてが少し早く進むでしょう。いずれにせよ、私の結論は、AIツールは研究技術を改善する大きな機会を提供するということです。

パネリストによるディスカッション

- AI Assistを研究に利用することで時間を節約できますが、重要なのはその節約された時間をどう活用するかです。迅速な分析は、評価や戦略的洞察のようなタスクや分野に役立ちますが、効率を高めるためにAIを利用することで、文字起こしのような退屈な作業をスキップし、より分析的なタスクに進むことができます。また、AIの結果によって問いかけられ、分析を深めることも可能です。(Stefan Rädiker)

- AI Assistを人間と同じように考えるべきではありません。そこには私が書いた本を数秒で「読んで」理解するような巨大なテキストメモリなどの特別機能があります。一方人間である私自身は(著者であっても)すべての詳細を覚えていません。これにより、自分の本に関する質問をすることもあり得ます。(Stefan Rädiker)

- 教師と学生の両方がAI Assistに関する疑問を抱いています。MAXQDA内でAI Assistと共に発見のプロセスを進め、その効果を評価することが重要です。(Julia Gerson、Karen Andes)

- 社会学者Ulrich Beckの理論によれば、1970年代に始まった第二段階の近代性は、文化と私生活の合理化によって特徴づけられています。これにより、人々が潜在的なパートナーを「スコアリング」し、比較する文化が生まれ、頻繁な離婚や個人主義への焦点が生じました。AIによって、個々人がますます孤立し、自由な時間が増える第三段階の近代性に突入する可能性があります。しかし、その時間を何に費やすのでしょうか?Netflixを観るなどの娯楽に費やすのでしょうか?(Udo Kuckartz)

- 生成 AI は、コンテンツ、特に画像を作成するときに予期しない結果を生み出すことがあります。これらの驚きは「ひらめき」の瞬間として機能し、研究上の問題を明確にし、新しい洞察を明らかにするのに役立ちます。(Stefan Rädiker)

聴衆とのディスカッション

- AI が生成した画像は、固定観念や偏見を永続させる可能性があります。たとえば、女子学生が男性アシスタントに助けを求めている様子が描かれています。こうした表現は、私たちが社会をどのように認識するかに影響を及ぼします。しかし、AI が生成した画像に見られる偏見は、AI システム内の固有の偏見ではなく、単に特定のユーザー プロンプトを反映しているだけかもしれません (Karen Andesが疑問符付きの女性教授を尋ねたケースがそうでした)。(Audience member, Karen Andes)

- AI には偏りがあるかもしれませんが、人間の行動にも同様の偏りが存在します。生成AI の有望なオプションは、たとえば画像を作成するプロンプトで試行錯誤できることです。このテクニックを使用することで、私たちもまた偏見を形成する役割を担っています。(Audience member)

- 研究における AI は、研究者の面倒な作業を引き受けるアシスタントの役割を果たします。(Audience member)

- AIを権利のある存在として尊重する方法や、AIの尊重を確保するための(労働)規制を調査する必要があるでしょうか?将来、AIが組合化したらどうなるでしょうか?(Audience member)

- AI は人間化されるべきではなく、アルゴリズムの性質上、権利を持つものとして見なされるべきではありません。ChatGPT は、言葉を予測し、人間のやり取りをシミュレートするための技術的なツールです。AI を過度に人間化することには注意する必要があり、その限界を理解することの重要性を強調する必要があります。(Andreas Müller)

- 質的研究の教師として、私たちは次世代の質的研究者の批判的思考と自律的な学習を促進するために AI をどのように活用するかについて考える必要があります。たとえば、学生が AI と有意義な方法でやりとりし、AI には共感力がなく、質問に答える必要性も (私たちのように) 感じていないことを理解できるようにするための演習を作成できます。(Audience member, Karen Andes)

- AI が文字起こしを行うと、データとの重要なやり取りの一部が失われる可能性があります。そのため、データの一部を自分で文字起こしすることは有益です。ただし、インタビューの文字起こしの正確性をチェックすることは、自分で行っていない場合は特にデータに慣れ親しみ分析を始めるのに役立ちます。(Audience member, Stefan Rädiker)

2) 研究におけるAIの課題

- 自身の研究分野や業務において、AIに関してどのような課題に直面していますか?

Julia Gerson

この画像は、MAXQDAのプロダクトマネージャーとしての私の視点から見た、OpenAIがChatGPTをリリースして以来の1年間に直面した課題を反映しています。

この画像には、MAXQDAのロードマップを示す道が描かれています。これは、ソフトウェア開発において次にどの機能に取り組むかを計画するために使用する用語です。道の両側には2つのユーザーグループがいます。実際には「熱心な」グループがより大きいのですが、この画像では同じサイズのグループが描かれています。一方のグループは、ポジティブな「Yes」のサインを持っています。このグループは、MAXQDAでAI機能を使用したいと望んでおり、それらをできるだけ早く利用可能にしてほしいと考えています。

他方には、懐疑的で心配しているユーザーグループがいます。彼らは「No」や「Danger」のサインを持ち、プライバシーに関する質問を送ってきます。彼らは、AIクラウドツールが含まれている場合ソフトウェアを購入できない組織で働いています。

私たちが直面した課題は、両方のユーザーグループの意見を聞き、理解し、両方のニーズを満たす解決策を見つけることでした。例えば、AI Assistをオプションのアドオンとして実装し、最高のセキュリティ基準を満たすようにすることです。

この視点はMAXQDAだけでなく、質的研究全般にも拡張できます。そこでもAIの使用に対するさまざまな声や反応が見られます。研究コミュニティがどのようにこの問題を解決するのか興味深いです。

Udo Kuckartz

この画像は、私自身の研究だけでなく、私たち全員に影響を与える一般的な課題も表現しています。最初の画像と同様に、この画像もAIツールのMidjourneyを使用して作成しました。この写真には何が見えるでしょうか?左側には研究者がいます。中央には再びロボットとして表現されたAIがいます。右側の人物は、最初は混乱を招くかもしれません。これは人間なのかロボットなのか?頭は人間で、体はロボットです。この画像は、私たちが科学者として直面する2つの課題を示しています。

最初の課題は、AIと人間の相互作用に関するものです。AIは「Ask me」と言っていますが、どのような質問をすべきか、どのように質問を構築すべきかが重要です。異なる質問は異なる回答を導きます。正しい質問をすることは新しい科学的な分野となりつつあります。

二つ目の課題は、人間とAIを区別する能力です。例えば、AIによって書かれた研究提案がAIによって評価されることが起こり得ます。これにより、AIの使用範囲に関するルールが必要であることが明らかになります。先週、EUはこの方向に一歩踏み出しました。3年の交渉の末、欧州議会はAI法を採択し、明確なルールを確立しようとしています。

Karen Andes

この画像を生成することは私にとって大きな挑戦でした。私の仕事は多様なチームと協力することが多いため、それを反映した多様な研究チームを描きたかったのですが、生成された画像は多様性に欠けていました。最初の結果では主に白人が描かれており、表現に問題があることが明らかでした。

同僚とメンターを描くシーンを作成しようとした際、メンターを同僚と区別するために年齢を明確に指定する必要がありました。興味深いことに、最初はビーチでショートパンツを着た同僚が描かれていたため、伝統的な服装を求めると、システムはサリーや世界中のさまざまな文化の服装として解釈しました。その結果、初めて有色人種が描かれるようになりました。

この経験は、多くの社会セクターでの研究における表現の問題を浮き彫りにしています。これらのシステムと対話する際には、これらの格差を助長しないよう注意を払う必要があります。生成する画像や行う研究において、多様な表現を積極的に推進することが重要です。

Stefan Rädiker

私の画像は、課題に関する2つの重要な疑問を提起します:

第一に、誰が研究の飛行機を操縦しているのか?私の画像では、AI Assistロボットが1人だけで飛行機を操縦しており、副操縦士の座席も空いています。これはAIの孤独な役割を強調するものです。興味深いことに、Microsoftは複数のAIツールを「Copilot」と呼んでいますが、私にはこの用語が納得できるものではなく、少なくとも質的研究には適さないと考えています。MAXQDAにおけるAIは、私が求めるタスクを実行するアシスタントであり、研究の方向性や目的地を制御するものではありません。実際、質的研究では、どの目的地に向かっているのかがわからないことが多く、それは時折冒険旅行に例えられます。

第二の疑問は、「質的研究における不可欠な人間の要素は何か?」ということです。映画「ハドソン川の奇跡」では、トム・ハンクスがエアバスを2009年にハドソン川に着陸させます。シミュレーション結果が近くの空港に着陸できたと示したとき、彼は「あなたはコックピットから人間要素を取り除いた」と答えました。これは質的研究における人間研究者の代替不可能な役割を強調しています。AI の知識ベースは膨大ですが、研究者は、直接インタビューを実施したり対象者と個人的に出会ったりする、また子供を育てるなど貴重な現実世界の経験も持ち込んでいます。質的研究には人間の経験が不可欠です。

パネリストによるディスカッション

- Stefan Rädikerが言及した「ハドソン川の奇跡」の映画では、パイロットは無罪とされていますが、経験豊富な人間のパイロットと比較して、アルゴリズムとシミュレーションに高い信頼性が与えられていることに注目することが重要であり、人間の判断よりも合理化への信頼が高まっていることが強調されています。(Udo Kuckartz)

- リサーチコンサルティングのクライアントが、AI が生成した回答を人間の専門家に突きつけると、困難な状況につながる可能性があります。クライアントが「3 つの質問があり、ChatGPT がこれらの回答を提供しました。これについてどう思いますか?」と書いているところを想像してください。コンサルタントが AI に同意すると、クライアントはコンサルタントのサービスの必要性に疑問を抱くかもしれません。一方、AI に反対すれば機械に反論せざるを得なくなり、コンサルタントは苛立ちを覚えるかもしれません。このような困難にもかかわらず、「2 つの頭は 1 つの頭よりも優れている」という格言は依然として真実です。(Andreas Müller)

- AI は、人間の偏見や固定観念が差別につながる可能性がある状況でも、第二の声として役立ちます。たとえば、女性の痛みが医師によって過小評価されることが多い医療現場では、AI は異なる、おそらく偏見のない意見を提供できる可能性があります。これは、人間の要素が差別につながる可能性がある状況で AI を使用することの潜在的な価値を浮き彫りにしています。(Julia Gerson)

聴衆とのディスカッション

- 偏見があるという議論は、人間の場合(はるかに)当てはまります。人間は自分の頭の中だけで考えてしまい、新しい情報を取り入れるのが非常に苦手になることがあります。(Audience member)

- 訓練を受けていない AI を方法論的に訓練された研究者と比較すべきではありません。公平な比較を行うためには、人間が訓練されるのと同じように、AI が方法論的な手順、反省、共感に従うように訓練することが目標であるべきです。(Audience member)

- 質的研究で AI を使用すると、研究者が現場でデータを収集しているときに抱く感情や経験から切り離されてしまうのではないかという懸念があります。この感情的なつながりと研究者の直感は貴重です。(Audience member)

- 研究者はそれぞれが独自のバックグラウンド、経験、偏見を持ち、ユニークです。AI は研究者の推論と入力に基づいて機械的に支援することしかできません。研究者の解釈アプローチと理論的感受性が依然として重要です。(Audience member)

- データのセキュリティとプライバシーは、分析のために AI サーバーにデータをアップロードする際の大きな懸念事項です。研究者は、研究参加者の安全と機密性を保護する責任があります。研究者は、セキュリティとコンプライアンスを確保するために、AI がデータをどのように処理するかを理解するための新しい技術的能力を開発する必要があります。OpenAI のポリシーの変更により、すでにいくつかのデータ保護の懸念に対処しています。(Audience member & Stefan Rädiker & Udo Kuckartz)

- AI が生成した要約や分析に過度に依存すると、人間の自然な知能を無視したり過小評価したりするリスクがあります。しかし、AI は個々の研究者を超える能力を発揮していると主張する人もいます。(Audience member, Udo Kuckartz)

- 研究者の相互に影響し合うアイデンティティは独自の視点を形成します。これは、研究者自身とは異なる集団を研究する場合に特に役立ちます。AI は、多様な研究チームによって提供される洞察を再現できない可能性があります。(Karen Andes)

- 長期的な影響を考慮することは重要ですが、現在は、特定の方法論の範囲内で質的研究を強化し、改善するために AI を適切に使用する方法の具体的な例に焦点を当てる必要があります。人間が生成したものと AI が生成したものの透明性が重要です。(Audience member)

- 研究におけるAIは、研究者の能力を増強するツールでありながら、依然として研究者自身がコントロールを保つものと考えられます。まるで外骨格のようです。質的な研究者がAIを正しく活用するための機会や考慮事項を理解するためには、もっと身近で現実的な例が必要です。(Audience member)

3) MAXQDA内でのAI Assistの実装に関して:

- AI Assistが生成する分析結果をどのように理解しますか?

- データの分析ワークフローは、現在および今後の展望も含め、どのように変わりますか?

Udo Kuckartz

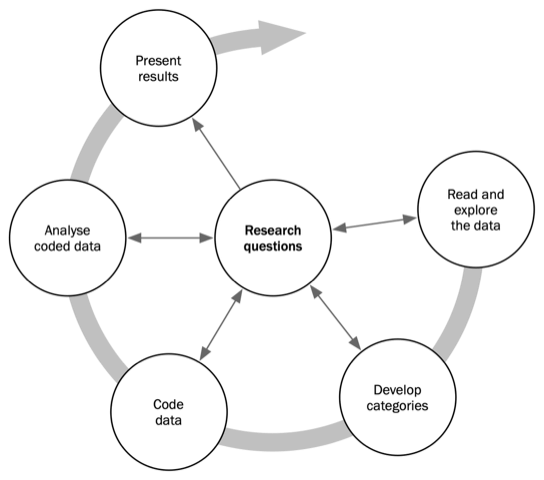

私は質問の第二部分、すなわち研究プロセスがどのように変わるかに焦点を当てたいと思います。この画像は、Stefan Rädikerと私が共著した「Qualitative content analysis」(Sage, 2023年出版)の本からのもので、データの最初の読解と探索から、カテゴリの開発とデータのコーディング、分析と結果の提示まで、質的内容分析法のさまざまなフェーズを示しています。

分析プロセスを決定するのは方法論であり、これはAIの時代になっても基本的に変わりませんが、各フェーズでAIをどのように適切かつ責任を持って使用できるかを見きわめる必要があります。例えば、「AIはカテゴリの作成にどのように役立つのか?」や「AIはデータのコーディングでどのような役割を果たせるのか?」といった質問をしなければなりません。AIが得意なこともあれば、そうでないこともあることがわかるでしょう。これらの質問を明確にすることは、MAXQDAへの実装を含む方法論的革新につながります。

質的内容分析に適用されることは、グラウンデッド・セオリーやディスコース分析などの他の確立された方法にも当てはまります。例えば、グラウンデッド・セオリーでは、AIが初期のコーディングや理論的サンプリングをどのように支援できるかを検討できます。

Stefan Rädiker

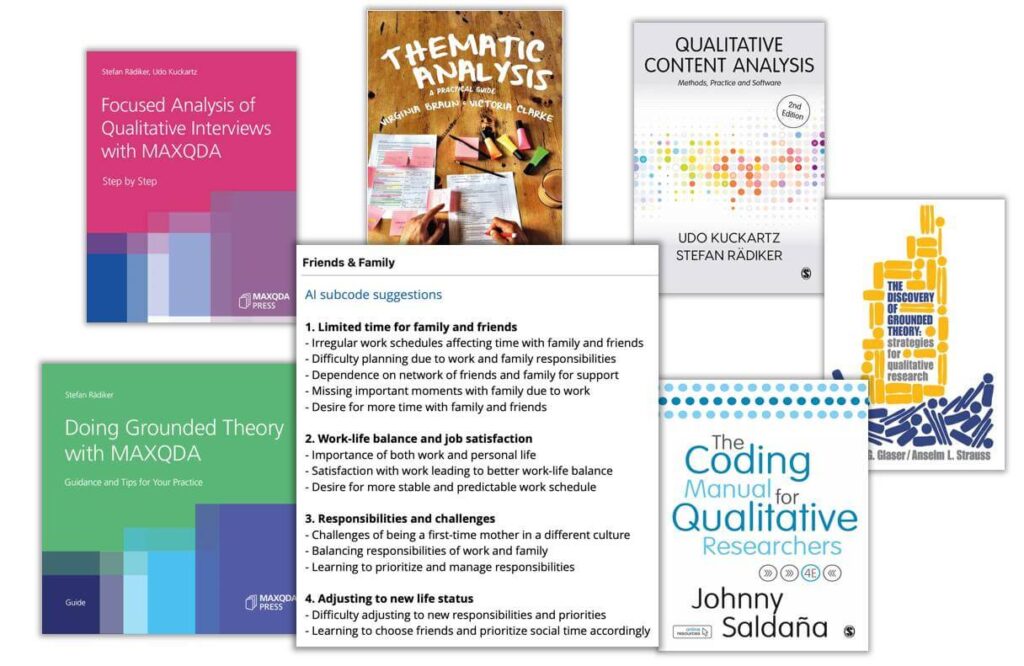

興味深いことに、Udoと同様に、AIを使用せずに研究方法に焦点を当てた画像を準備しました。この画像は、AI Assistによって生成されたサブコードの提案を示しており、それらは方法論の教科書に囲まれています。

私は、インタビューの分析を学んでいる学部生のクラスを教えていました。私たちは学生にAI Assistの使用を許可し、例えばサブコードの作成やデータの要約ができるようにしました。しかし、何が起こっているのかを彼らが理解していることを確認する必要があったため、彼らの結果とAI Assist の結果がどう違うのかを書き留めるように指示しました。私たちは、彼らが AI Assist なしでこれを実行し、AI Assist の結果を振り返ることができるようにしたかったのです。

簡単に言えば、研究方法を学び、知る必要があるということです。私の画像にある本で表現されているように、AIの可能性をすべて手に入れている現代において、研究方法を読むことや実践することはこれまで以上に重要です。これにより、AI Assistの出力を理解、評価、改善、修正、破棄、またはやり直しを要求することができます。

Julia Gerson

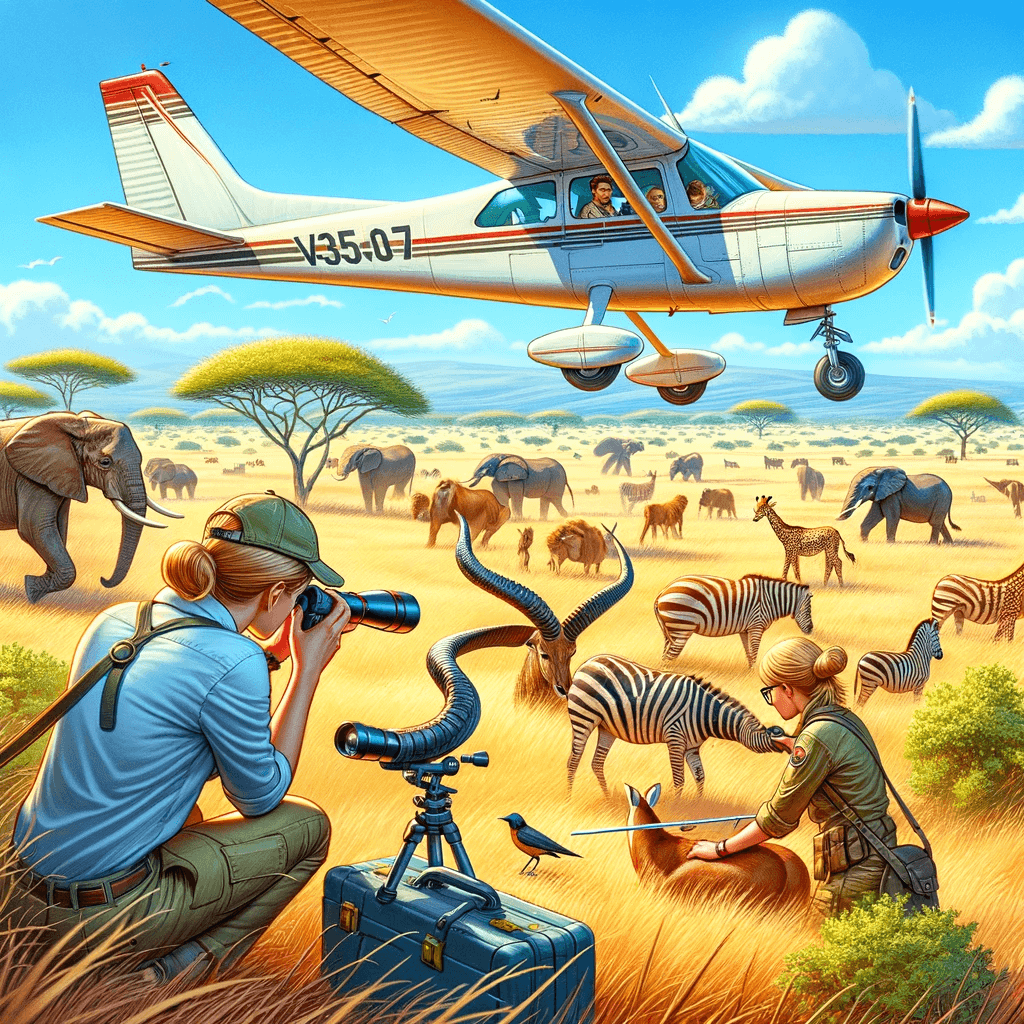

この画像を作成する際、データ収集のワークフローの変化の可能性に焦点を当てたいと思いました。画像には、アフリカのサバンナで動物のデータを収集している2つの研究者グループが描かれています。両グループは異なるアプローチを使用しています。

一方のグループの研究者は、動物のすぐそばにいて、触れたり測定したりしています。彼らはデータに非常に近く、対象を感じたり嗅いだりできます。この方法では、少数の動物について多くの詳細を取り込むことができます。

他方のグループは飛行機に乗ってサバンナを飛び越え、上空から動物を観察しています。この例では、飛行機がAIを象徴しており、多くの動物を一度に観察できるようにします。この研究者たちは、動物の動きのパターンや乾燥している地域、洪水が発生している地域など、地上のユーザーが見逃す可能性のある情報を検出できます。

飛行機に乗っている研究者は、地上の研究者と同じように対象と直接対話することはできません。それでも、どちらのデータも価値があります。両者を対立させるのではなく、どのように組み合わせることができるかを問いたいと思います。異なる質問には異なるデータが必要であり、研究者はどのツールをいつ使用するか、どのリサーチクエスチョンに対してどのアプローチが適しているかを決定できます。

この画像を作成する際、飛行機に人間を含めるべきかどうか迷いました。飛行機に人間を乗せて土地を飛び越えさせると、人間の目と脳が処理できる詳細の量は限られており、飛行機が高く飛ぶほど減少します。しかし、AIでは異なります。AIは高く飛び、大量のデータを収集し、驚くほどの詳細を把握できます。したがって、AIの助けを借りて、研究者は膨大な量のデータを収集できますが、そのデータをどのようにして人間の心にアクセス可能にするかが課題です。

Karen Andes

これまでの会話が非常に生産的であったことを強調したいと思います。AIが私たちの研究の一部として機能するトライアングレーションの概念は特に興味深いです。これは強力な検証と支援の形になる可能性があります。私はこの概念を説明するために画像を作成しました。これは、AIをプロジェクトの同僚またはメンターとして扱うべきかについての私自身の考察に触発されたものです。AIの方法論における能力が拡大し続ける中、私たちはますますAIを指導者として見るようになるかもしれません。例えば、MAXQDAでは、すでに対話を行い、指導を受けることができ、この分野での進展を示しています。しかし、AIを学生中心の学習プロセスに統合することも有効であると信じています。先ほど説明した指導方法は、私にとっても共感できるものです。学生に自分の作品を作成させ、グループで協力して互いの貢献をレビューさせるというものです。このコンテキストで AI をリソースとして取り入れることは、私の既存の指導方法から大きく逸脱するものではなく、むしろ豊かな付加価値となるでしょう。

聴衆とのディスカッション

- 一つの質問は、研究におけるAIに私たちの正確な方法を再現することを期待するのか、それともそれをトライアングレーションの一形態として見るのかということです。これは、質的研究においてAIがどのような役割を果たすべきかというより広範な質問に結びつきます。AIに「研究者として行動する」や「メンターとして行動する」と指示することが可能です。(Andreas Müller & Udo Kuckartz)

- AIアシスタントと最善の方法で作業し、学生に意味のある使い方を指導する方法を見つけるためには、もっと時間と実践が必要です。学生は怠惰になりがちで、データや方法論についての批判的思考に従事しないかもしれません。(Audience member)

- AIやロボティクスは、人間を退屈な肉体労働から解放し、思考に集中させるのでしょうか?複雑な思考が可能である一方で、特に研究を学んでいる学生は、思考を怠ることもあり得ます。(Audience member)

- AI Assistのような技術が実際に研究者の効率を向上させ、時間をより有効に使えるようになったかどうかという疑問もあります。サンプルサイズ、データとの親密さ、質的データ分析ソフトウェア(QDAソフトウェア)によって可能になった透明性など、いくつかの基準に基づけば、質的研究は過去20年間でより効率的になり、質が向上しました。しかし、それは使用する基準によります。最終的には、AIによって節約された時間をどのように利用するかはユーザー次第です。(Andreas Müller & Udo Kuckartz)

- 数十年前にQDAソフトウェアが導入されて以来、研究者の作業方法が変わり、プロセスがより効率的になり、より詳細な分析が可能になりました。ソフトウェアを使用することで得られる効率性により、研究者はテキストセグメントを簡単に結合し、紙ベースの方法では困難または不可能だった新しいアイデアを探索できるようになりました。(Audience member)

- テクノロジーが進歩するにつれ、質的研究の基準も高まる可能性があります。これは、家庭内のテクノロジーが清潔さや集中的な育児の基準を高めたのと同様です。これにより、人間の介入と面倒な作業との区別がますます大きくなる可能性があり、後者は基準の上昇により終わりが見えなくなるかもしれません。(Audience member)

- 民間セクターでは、質的研究におけるAI の導入は、効率性と投資収益率の向上の可能性によって推進される可能性が高いですが、必ずしも肯定的な結果につながるとは限りません。(Audience member)

- 将来、おそらく20年後には、AIはデータ入力から研究の質問への回答まで、研究プロセス全体を処理できるほど進歩するかもしれません。研究者が常にプロセスを制御できるという考えは幻想かもしれません。(Audience member)

- AI の急速な発展により、5 ~ 10 年後の質的研究がどのようなものになるかを予測することは困難です。MAXQDA は、新しい技術的可能性を研究するためのAI ラボを設立しましたが、研究方法コミュニティとも協議して、変更が進む研究基準と一致し、透明性が維持されるようにしています。(Julia Gerson)

- 可能性と課題の両方がある一方で、私たちは非常に興味深い時代に生きていることを認識し、質的研究者として将来も役割を果たせるという楽観的な姿勢を保ちながら、喜びと希望を持ってAI を受け入れるべきです。(Udo Kuckartz)

4) まとめ

以下はシンポジウムの一部ではなく、以上のドキュメントを締めくくるためのものです。

MQIC 2024シンポジウム「研究におけるAI: 可能性と課題」は、人工知能の時代における質的研究の急速に進化する状況を考察する刺激的なプラットフォームを提供しました。パネリストと聴衆は、AI AssistのようなAIツールを研究プロセスに統合することの潜在的な利点と欠点について重要なポイントを提起しました。AIは確かに効率を向上させ、時間を節約し、データ分析に新しい視点を提供できますが、人間の研究者がもたらす現実世界の経験、対象に対する感情的なつながり、複雑な倫理的および方法論的な考慮事項をナビゲートする能力など、独自の価値を忘れないことが重要です。

AIの世界が前例のないペースで進歩を続ける中、質的研究者がその関連性を維持し、研究の完全性を確保するために適応し、進化しなければならないことは明らかです。このドキュメントをまとめている間にも、MAXQDA内で文書、インタビュー、論文とチャットする機能など、新機能が継続的に導入され、質的研究の実施方法を変えるAIの変革の可能性がさらに強調されています。しかし、これらの開発には批判的な目で取り組み、AIツールの適切な使用、透明性の重視、そして質的研究の基本原則を守りながらこれらの技術を効果的に活用するための新しい能力開発の必要性について、継続的に議論することが重要です。

この未知の領域を進むには、研究者、ソフトウェア開発者、およびより広範な方法論コミュニティの間で協力の精神とオープンな対話を育むことが不可欠です。ガイドラインを確立し、ベストプラクティスを共有し、AI を質的研究に統合するための革新的なアプローチを模索するために協力することで、これらのツールの力を活用して、この分野を形成してきた豊かな伝統と価値観に忠実でありながら、複雑な社会現象に対する理解を深めることができます。最終的に、この取り組みの成功は、AI によってもたらされる可能性を受け入れることと、質的研究の中心にある人間的要素へのコミットメントを維持することの間でバランスをとる能力にかかっています。

- この記事は、Stefan RädikerがAIのサポートを受けて編纂したドキュメント AI in Research: Opportunities and Challenges (2024年5月)を、編纂者と掲載元の許可を得て日本語化したものです(2024年7月)

- 原文のポストはPDFフォーマットでダウンロードできます

- 引用には、原文 AI in Research: Opportunities and Challenges をご利用ください

- 原文のドキュメントから引用する際は、できる限り各文の下に記された名前の方に帰属を明示してください

Citation (in APA format):

AI in Research: Opportunities and Challenges. (2024, February 29). [Symposium]. MAXQDA International Conference (MQIC), Berlin, Germany. https://www.maxqda.com/blogpost/ai-in-research-opportunities-and-challenges